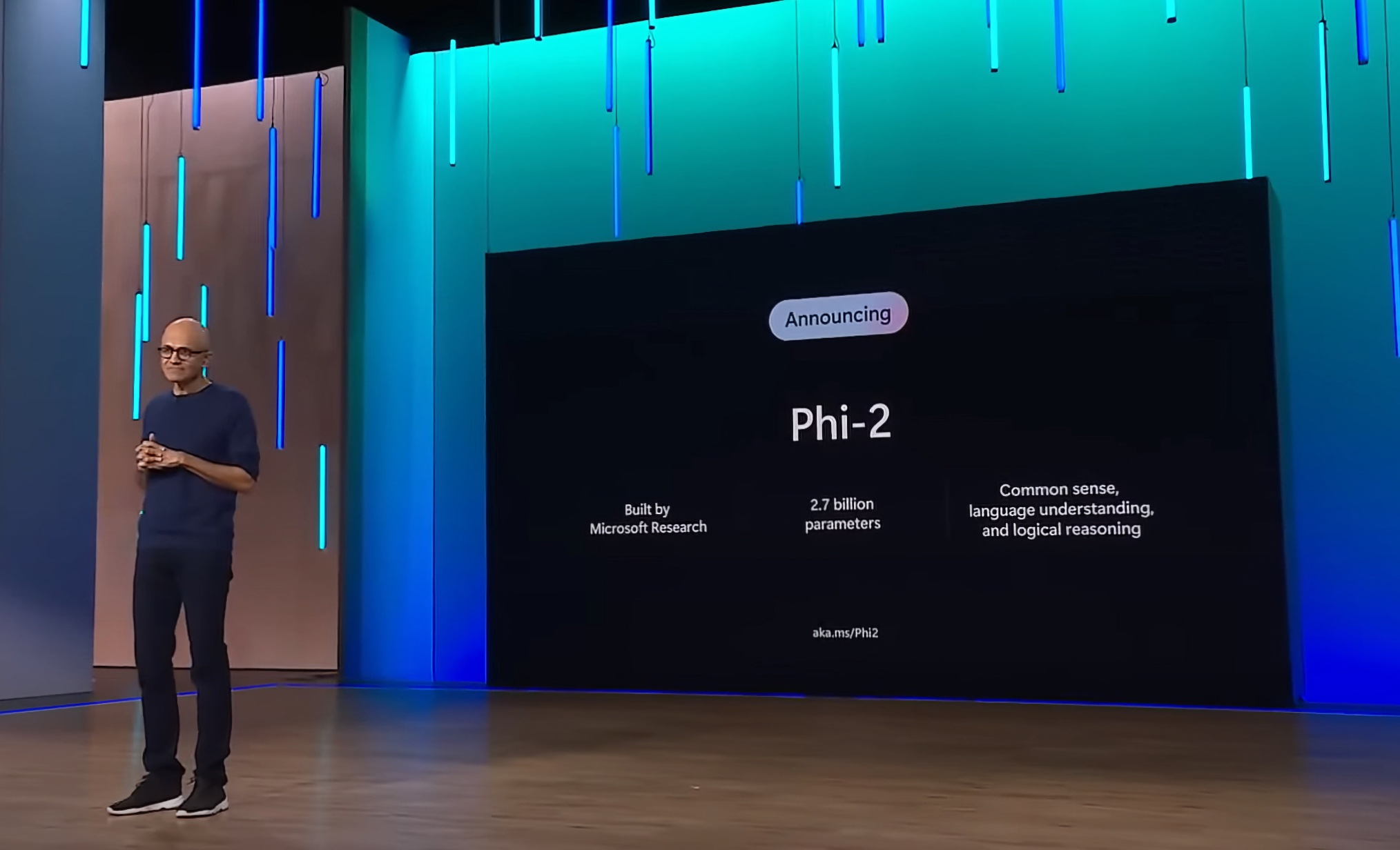

微软的 27 亿参数模型 Phi-2 展示了出色的推理和语言理解能力,为参数少于 130 亿的基础语言模型的性能设定了新标准。

Phi-2在其前身Phi-1和Phi-1.5的成功基础上更进一步,凭借在模型扩展和训练数据整理方面的创新,其性能可媲美或超越25倍大的模型。

Phi-2 体积小巧,是研究人员的理想乐园,有利于探索机理可解释性、提高安全性,以及在各种任务中进行微调实验。

Phi-2 的成就主要体现在以下两个方面:

Phi-2 经过了各种基准测试的严格评估,包括 Big Bench Hard、常识推理、语言理解、数学和编码。

只需 27 亿个参数,Phi-2 的性能就超过了包括 Mistral 和 Llama-2 在内的更大型的模型,并与谷歌最近发布的 Gemini Nano 2 不相上下,甚至更胜一筹:

除基准测试外,Phi-2 还展示了其在真实世界场景中的能力。涉及研究界常用提示的测试显示,Phi-2 在解决物理问题和纠正学生错误方面表现出色,展示了其超越标准评估的多功能性:

Phi-2 是一个基于变换器的模型,以预测下一个单词为目标,在来自合成和网络数据集的 1.4 万亿个词库上进行训练。训练过程在 96 个 A100 GPU 上进行,历时 14 天,重点是保持高度的安全性,并声称在毒性和偏差方面超越了开源模型。

随着 Phi-2 的发布,微软将继续推动小型基础语言模型的发展。

上一条: 新西兰域名机构:为什么注册.NZ域名?

下一条: 谷歌云发布Imagen2文本到图像生成器