NVIDIA今天在SC19上发布了许多重要公告。首先,NVIDIA引入了一个参考设计平台,该平台使公司能够快速构建基于GPU的Arm加速服务器,从而推动高性能计算的新时代,为科学和工业中越来越多的应用程序提供了支持。

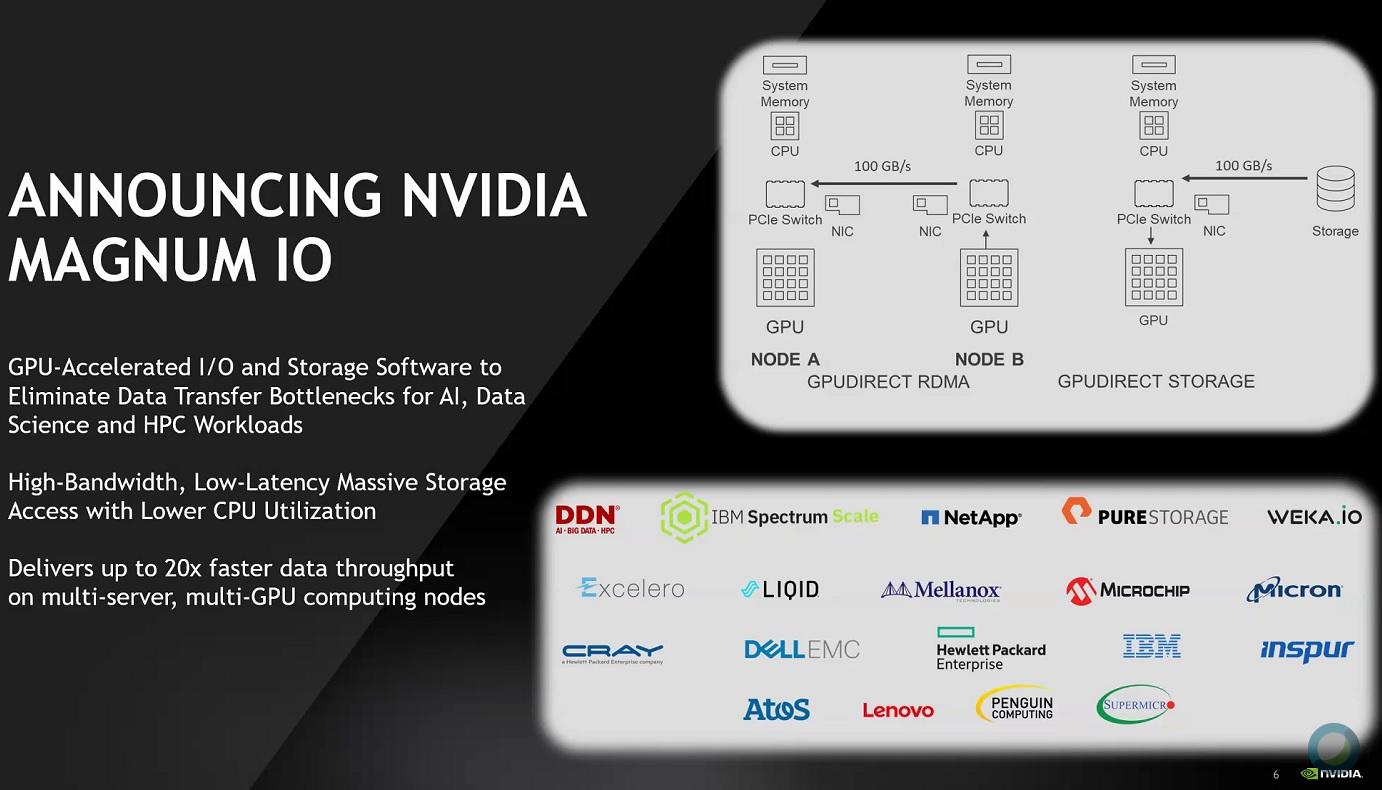

其次,它推出了NVIDIA Magnum IO,这是一套软件,可帮助数据科学家和AI以及高性能计算研究人员在数分钟而不是数小时内处理大量数据。在第三次宣布中,NVIDIA宣布了可在Microsoft Azure上使用的新型云加速GPU超级计算机。

让我们解开这些公告及其对NVIDIA以及整个数据和计算生态系统的意义。

高性能,低功耗,强大的生态系统

最近,英特尔在数据中心的几乎垄断地位正受到威胁。除了设法替代英特尔CPU的AMD之外,ARM也带来了新的竞争。 由于其低功耗,到目前为止,ARM处理器主要用于移动电话和边缘计算方案。

分析师称,尽管Arm处理器的性能在这一点上可能无法与Intel相提并论,但其节俭的电源需求也使它们成为数据中心的诱人选择。AWS在2018年率先发挥了这种优势,在其武器库中添加了使用Arm CPU的新实例。通过新宣布的对Arm CPU的支持,NVIDIA实现了许多目标。

首先,NVIDIA的未来将证明自己,并增强其生态系统和软件平台。通过拥抱Arm,NVIDIA使各地的云供应商和数据中心经理知道他们可以期望NVIDIA GPU在任何可能使用的CPU上无缝运行。NVIDIA首席执行官黄仁勋明确表示:

“高性能计算正在复兴。机器学习和AI的突破正在重新定义科学方法并为新架构带来令人兴奋的机遇。将NVIDIA GPU引入Arm为创新者创建创造了闸门系统,用于将新应用程序从超大规模云扩展到百亿亿次超级计算等等。”

NVIDIA正在发挥其软件力量,并通过Magnum IO扩展其生态系统,并支持Arm处理器。图片:NVIDIA

同时,NVIDIA将Arm及其生态系统合作伙伴(包括Ampere,Fujitsu和Marvell)带入NVIDIA软件生态系统及其CUDA-X软件平台。正如我们过去指出的那样,创新型初创公司正在追寻NVIDIA在AI芯片市场上的领先地位。尽管初创公司可能会提出新的硬件设计,但是NVIDIA的软件堆栈将很难匹配。对于Arm来说,像NVIDIA这样的合作伙伴肯定会使采用的前景看起来好得多。

NVIDIA和Arm都强调了这一生态系统方面。但是,除了Arm之外,NVIDIA还更广泛地提到了HPC(高性能计算)生态系统。除了使自己的软件与Arm兼容之外,NVIDIA还与其广泛的开发者生态系统紧密合作,将GPU加速带入ARM的HPC应用程序,例如GROMACS,LAMMPS,MILC,NAMD,Quantum Espresso和Relion。

NVIDIA及其HPC应用程序生态系统合作伙伴已编译了广泛的代码,以将GPU加速带入Arm平台上的应用程序。为了实现Arm生态系统,NVIDIA与领先的Linux发行商Canonical,Red Hat,Inc.和SUSE以及业界领先的基本HPC工具提供商合作。

竭尽全力进行创新:从边缘到数据中心,然后再返回

但是这里还有更多的事情。Huang最近将边缘技术作为NVIDIA的主要目标。在最近的2019年第三季度与分析师的电话会议中,在NVIDIA推出其针对边缘AI的EGX计算平台之后,黄坚决表示:``

本季度,我们奠定了AI最终发挥最大影响力的基础。 GPU加速的5G,人工智能和物联网将彻底改变世界上最大的行业。在对话式人工智能和推理的推动下,我们看到数据中心的强劲增长。”

确实,NVIDIA预见了边缘工作负载的增长,并希望为此做好准备。除了另一个最近通过与爱立信,红帽和微软合作伙伴关系针对5G的生态系统扩展,NVIDIA还推出了其Jetson系列的SoM(系统级模块,具有CPU,GPU,PMIC,DRAM和闪存)。

这些SoM非常适合边缘应用程序,但它们并不是市面上唯一的游戏。Arm也有自己的处理器产品线,以适应边缘的AI工作负载。现在Arm和NVIDIA可以很好地合作,这意味着在将来,我们还可以在边缘部署的设备和应用程序中看到Arm和NVIDIA处理器的组合。

NVIDIA新推出的Magnum IO软件堆栈极大地推动了GPU驱动的数据分析和AI工作负载。图片:NVIDIA。

玛格南宣布的情况也是如此。Magnum IO的核心是GPUDirect,NVIDIA称其为数据提供了一条绕过CPU并在GPU,存储和网络设备所提供的“开放高速公路”上行驶的路径。Magnum与包括NVIDIA NVLink™和NCCL以及OpenMPI和UCX在内的各种通信互连和API兼容-GPUDirect由对等和RDMA元素组成。

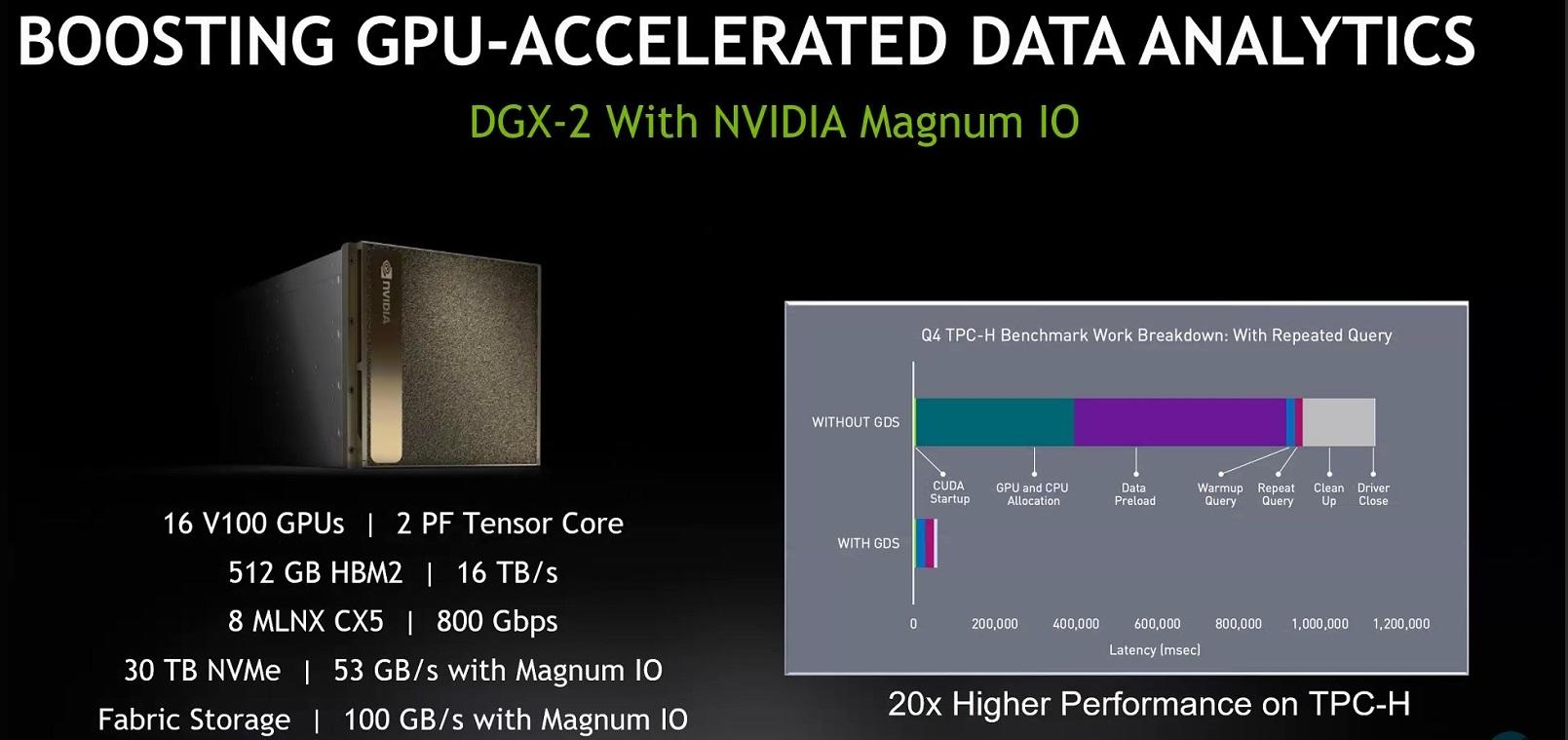

NVIDIA指出,Magnum IO经过优化,可消除存储和输入/输出瓶颈,并在与海量数据集一起进行复杂的财务分析,气候建模和其他工作时,为多服务器,多GPU计算节点提供高达20倍的数据处理速度。 HPC工作负载。

Magnum除了为将由Magnum IO来增加工作量的所有人赢得巨大胜利之外,Magnum还增强了NVIDIA的生态系统,并扩大了其在软件方面的领先优势。NVIDIA与网络和存储领域的行业领导者密切合作开发了Magnum IO,其中包括DataDirect Networks,Excelero,IBM,Mellanox和WekaIO。

就软件而言,只要问问自己,AI芯片新贵不仅可以开发Magnum IO之类的产品,而且可以像NVIDIA一样让其他硬件供应商参与其中。当被问及Magnum IO的生态系统方面以及是否对其他供应商开放时,Ian Buck,NVIDIA VP和GM Accelerated Computing表示赞同。

但这并不意味着NVIDIA不在这里。要挑战其在数据中心地位的新贵要么不得不与Magnum IO一起竞争,要么重新发明它。Magnum IO可能是开源的,但并非并非没有领导。

在AI硬件市场再次创新,其中很多

无论如何,Magnum IO带来的性能提升似乎都是巨大的,拥有数据科学和AI工作负载并在其数据中心或云供应商中利用NVIDIA GPU的用户应注意这一点。例如,NVIDIA关于Microsoft Azure的新NDv2实例的最大部署的最终公告。

NVIDIA说NDv2跻身全球最快的超级计算机之列,可在单个Mellanox InfiniBand后端网络上提供多达800个互连的NVIDIA V100 Tensor Core GPU。NDv2使客户可以从他们的办公桌上按需租用整个AI超级计算机,并与可能要花费数月部署的大型本地超级计算机相匹配。

SC19当然是这些公告的合适场所。但是,这些应用程序及其含义远远超出了HPC。AWS基础设施副总裁Peter DeSantis最近表示,我们在AI硬件市场再次看到了创新,其中很多创新。